从一张图片看人工智能的局限

上周,挪威作家 Tom Egeland 在 Facebook 上发布了一张以纪念越战为主题的贴文,并附了一张美联社记者拍摄的照片 “烧夷弹的女孩”(Napalm Girl)。

这是张著名的历史照片。

1972 年,美联社记者尼克·崴在越南捕捉到越南女孩因为被汽油弹炸伤,浑身赤裸奔跑,表情痛苦的场景,并拍摄下来,后来获得了普利策新闻奖。

但荒谬的是,因为发布了这张照片, Egeland 的 Facebook 个人帐号就被禁用了、照片被删除。Egeland 还收到了来自 Facebook 的简讯,解释其删除 “烧夷弹的女孩” 照片的理由是:

“ 任何关于展示了全裸的外生殖器、臀部和完整女性胸部的照片,都会被删除。”

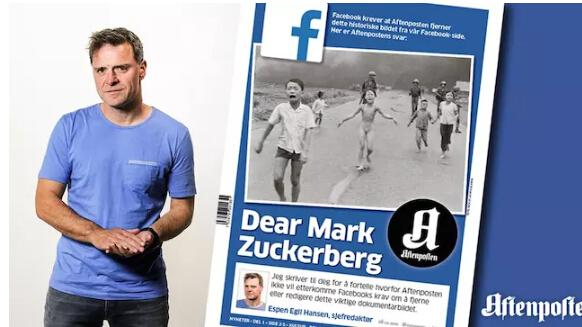

随后,挪威报纸 Aftenposten 的主编 Espen Egil Hansen 给马克·扎克伯克写了一封公开信, 其中指责说 Facebook 的审查算法分不清儿童色情和新闻图片的区别。

后来又有多名挪威人转发了该图片,包括挪威首相索尔伯格,但他们发的内容无一例外都被删除。

挪威报纸《Aftenposten》在头版刊登公开信,谴责脸书

这件事儿引发了大量媒体的关注。事件发酵两天后,Facebook 最终撤销了照片的封杀令,并表示:听取用户的意见,并肯定了照片的历史意义。

现在,你在 Facebook 上所看到的内容,大多依靠算法根据你的兴趣来进行挑选,前不久,Facebook 就裁撤了“热门话题”人工编辑团队,全权交由算法来决定新闻内容的热门程度。

此次越战女孩儿的照片就被算法自动划归为了儿童色情类,进行系统删除。

这已经不是 Facebook 第一次删除这类照片。此前,它的算法还自动清理了不少与叙利亚、伊拉克和土耳其战乱有关的图片。

Facebook 的算法还挺聪明,一下就能认出照片里是人类裸体。

遗憾的是,战争中的照片许多时候就是不让人们轻松愉快的。它们被战地摄影师拍下,并由媒体刊发,是为了将现场的真实情况告诉世人。

而 Facebook 的算法还领悟不到二者的区别。这大概也是人工智能现在的局限。